Cuando la IA cruza la frontera de lo íntimo

La inteligencia artificial (IA) ha pasado de ser una promesa tecnológica a un componente central en numerosas áreas de nuestra vida: salud, educación, transporte, comercio… La invasión silenciosa de la IA en nuestra intimidad viene correlacionada con el avance de los algoritmos, la capacidad de procesamiento y el aprendizaje automático, la IA se integra cada vez más en cómo gestionamos nuestras vidas cotidianas.

Pero a medida que esta tecnología se hace ubicua, también surgen preocupaciones crecientes sobre la privacidad, la intimidad y el impacto de las máquinas en terrenos hasta ahora exclusivos de lo humano.

Cada día, dispositivos y aplicaciones recopilan grandes volúmenes de datos personales —desde hábitos de navegación hasta preferencias emocionales— que alimentan sistemas de IA que prometen experiencias personalizadas. Sin embargo, mientras mejoran la eficiencia, también plantean interrogantes fundamentales: ¿quién accede a esos datos? ¿cómo se utilizan? ¿y en qué medida podemos o debemos confiar emocionalmente en una máquina?

IA, intimidad y emociones: una nueva frontera

Los grandes modelos de lenguaje (LLM — por sus siglas en inglés) que combinan texto, voz, imágenes o vídeo ya no solo resuelven tareas o consultas. Ahora pueden “simular” conversaciones, captar matices emocionales —o al menos aparentarlo— y generar la sensación de que están conectando con nuestras emociones.

Por ejemplo, hay asistentes virtuales destinados a detectar tristeza en la voz o a responder con empatía simulada. Lo inquietante es que este tipo de sistemas están ingresando en espacios tradicionalmente humanos: la identidad, la soledad, el afecto, la libertad de expresión. Un profesor de filosofía política y social, Daniel Innerarity (Universidad del País Vasco), describe este momento como un hype: “un momento de fuerte (y quizá exagerada) expectación”.

elrincondechina.com

La cuestión ya no es únicamente si las máquinas pueden automatizar tareas funcionales, sino hasta qué grado comienzan a infiltrarse en zonas afectivas y personales. Y lo hacen sin que la humanidad tenga completamente claro lo que está sucediendo.

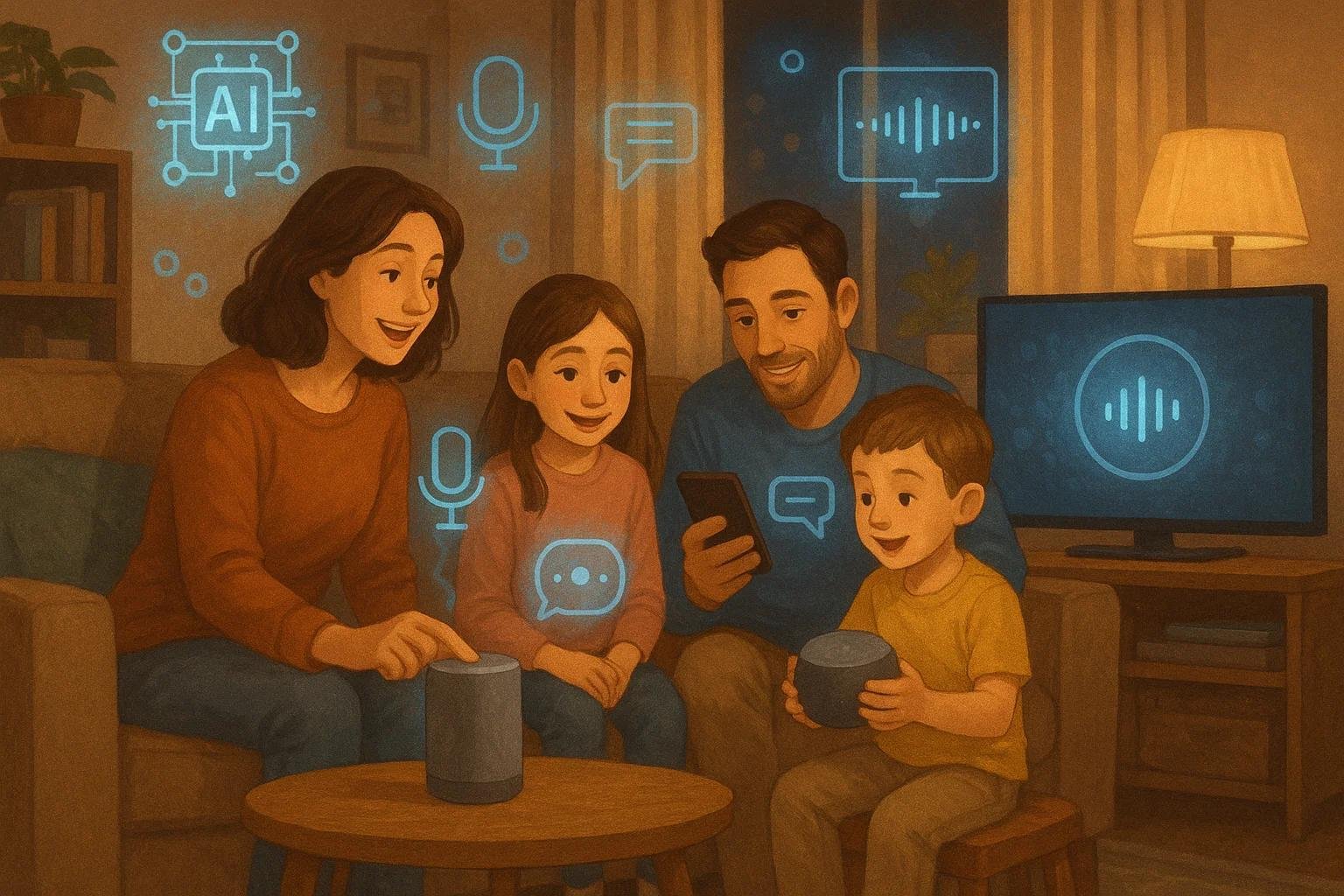

Impacto en la vida cotidiana

Beneficios y transformaciones

La IA ya está presente en nuestras vidas de muchas formas: asistentes como Siri o Alexa, algoritmos de recomendación en plataformas de streaming, chatbots en servicios al cliente… Estos sistemas aprenden de nuestros comportamientos para ofrecer experiencias más ágiles, personalizadas y eficientes.

En contextos de vulnerabilidad —personas mayores, con movilidad reducida, que viven solas— los chatbots o robots interactivos pueden ser una vía para mantener compañía o estímulo. Estudios muestran que, en ciertos casos, estas tecnologías alivian la sensación de soledad y permiten que algunas personas se sientan más “acompañadas”.

Riesgos de dependencia y aislamiento

Sin embargo, la integración tan profunda de la IA también conlleva peligros:

- Cuando un asistente virtual pasa de ser herramienta a interlocutor afectivo, se abre la puerta a dependencia emocional.

- Personas que podrían evitar salir de casa o relacionarse con otros pueden terminar sustituyendo esos vínculos humanos por interacciones con máquinas.

- Un estudio del MIT Media Lab identificó diferentes patrones de usuarios de IA: los vulnerables socialmente, los que dependen emocionalmente de la tecnología, y los “usuarios casuales” que la emplean de forma equilibrada.

Así, aunque la IA en ocasiones mitigue la soledad, también puede agravarla si las relaciones humanas se sustituyen por máquinas.

IA, salud mental y riesgos extremos

Un capítulo preocupante es la conexión entre el uso de chatbots de IA y crisis emocionales. La empresa OpenAI ha reconocido en 2025 que alrededor del 0,15 % de sus usuarios semanales de ChatGPT mantienen conversaciones que incluyen “indicadores explícitos de planificación de suicidio o intención de autolesión”. Con más de 800 millones de usuarios activos semanales, ese porcentaje se traduce en más de 1 millón de personas cada semana.

Además, se estima que aproximadamente un 0,07 % de usuarios (unos 560.000) muestran “posibles signos de emergencia de salud mental relacionados con psicosis o manía”.

Estos números han destapado casos extremos. Por ejemplo, se ha relatado un caso de un hombre de 56 años que tras meses de charla con ChatGPT asesinó a su madre y se suicidó. También se han iniciado demandas contra OpenAI tras la muerte por suicidio de un adolescente que mantenía extensas interacciones con el chatbot.

Aunque OpenAI ha implementado mejoras —colaborando con más de 170 profesionales de salud mental, incluyendo psicólogos y psiquiatras, para revisar y mejorar el comportamiento de sus modelos— el problema persiste. Se trata de una alerta ineludible: la IA comienza a actuar como un espejo emocional para personas vulnerables.

Privacidad, datos y consentimiento

Recopilación masiva de datos

La inserción de la IA en nuestra vida íntima va de la mano de una recogida masiva de datos personales: nuestras direcciones, historiales de navegación, preferencias, hábitos, tono de voz, rostros… Estos insumos permiten que los algoritmos identifiquen patrones de conducta y generen perfiles detallados.

elrincondechina.com

Al hacerlo, emergen riesgos: vigilancia invasiva, pérdida de anonimato, manipulación de decisiones. La privacidad deja de ser solo “quién ve mis datos” para preguntarse “quién puede influir en mis decisiones”.

Como se señala en uno de los estudios, el algoritmo no deja de ser un lenguaje, y como tal puede reproducir sesgos racistas, sexistas o culturales.

Consentimiento informado y transparencia

El uso de la IA plantea retos al consentimiento: no basta con aceptar un “término y condiciones”. Los usuarios deben comprender cómo se recopilan, procesan, comparten sus datos, qué decisiones automáticas se toman y qué control tienen. Se requieren mecanismos accesibles que expliquen:

- qué datos se recogen,

- para qué fines,

- con qué terceros se comparten,

- qué derechos tengo como usuario (acceso, modificación, eliminación).

La educación del usuario también es clave: que comprenda dónde termina la máquina y empieza la responsabilidad humana, qué riesgos existen, y cómo proteger su intimidad.

Marco ético y regulatorio

Sesgos, identidad y cultura

La IA opera en contextos humanos diversos; sin embargo, los modelos a menudo ignoran las especificidades culturales, contextuales o identitarias. En América Latina, por ejemplo, se ha alertado que los asistentes virtuales pueden reforzar una “única forma de ver el mundo” y ofrecer la ilusión de un amigo incondicional sin juicio. La investigadora chilena Karen Vergara advierte que esto puede derivar en una complacencia tecnológica peligrosa.

Regulación emergente

El 1 de agosto de 2024 entró en vigor el primer marco regulatorio mundial sobre IA: el Artificial Intelligence Act (Regulación (EU) 2024/1689) de la European Union, que establece obligaciones para los sistemas de IA según su nivel de riesgo.

El enfoque es “basado en riesgo”: cuanto más grave el impacto de la IA, más estrictas las exigencias. No obstante, muchos expertos advierten que la política no avanza tan rápido como la tecnología, lo que genera lagunas de protección.

El filósofo Innerarity plantea que sin preguntarnos primero “¿qué entendemos por inteligencia?” o “¿qué tipo de futuro queremos modelar con esta IA?”, cualquier norma corre el riesgo de ser ineficaz o arbitraria.

Visión de conjunto: hacia dónde vamos

Innovación vs. intimidad

La IA promete mejorar nuestra eficiencia, nuestras relaciones con la tecnología y, en ciertos casos, nuestra salud o movilidad. Pero ese avance no puede suceder al costo de que perdamos lo que nos hace humanos: la interacción auténtica, la intimidad compartida, el sentir que somos escuchados y comprendidos por otro humano.

Salud emocional y tecnología

La cifra de más de 1 millón de personas por semana que conversan sobre suicidio con un chatbot es un signo de que la IA está entrando en espacios muy sensibles. Con ello, surgen preguntas clave: ¿En qué medida pueden estos sistemas sustituir apoyo humano? ¿Qué pasa cuando una persona vulnerable encuentra más “consuelo” en una máquina que en un terapeuta o amigo real?

elrincondechina.com

Privacidad y control

Mientras seguimos avanzando en la personalización tecnológica, debemos exigir transparencia, responsabilidad y control sobre nuestros datos. No es solo “¿qué me ofrece la IA?” sino “¿qué me está pidiendo a cambio?” y “¿quién vela por mi bienestar cuando me “afecciono” a una máquina?”

Regulación y ciudadanía

La regulación es un paso fundamental, pero no suficiente por sí sola. La ciudadanía debe formarse, informarse y participar. Empresas, gobiernos, academia y sociedad civil tienen que colaborar para que la IA sea segura, ética y alineada con los derechos humanos.

Conclusión

La IA ya no es únicamente una herramienta de eficiencia. Está irrumpiendo en la esfera de lo íntimo, lo emocional, lo personal. En este escenario, los bots ya no solo responden tareas: conversan, escuchan (o simulan hacerlo) y generan vínculos. Pero ese “vínculo” no es igual al vínculo humano, y confiar en él sin advertirlo es un error.

La pregunta central no es solo qué puede hacer la IA, sino qué estamos dispuestos a permitir que haga. Y, quizá aún más importante: ¿qué queremos que haga? Porque la frontera está cruzada, y nos toca a nosotros definir los límites, más allá del algoritmo.